ATI Radeon HD 5570: Järkevää pelaamista 80 dollarilla?

Artikkelin kirjoittaja: Manu Pitkänen | 0 kommenttia

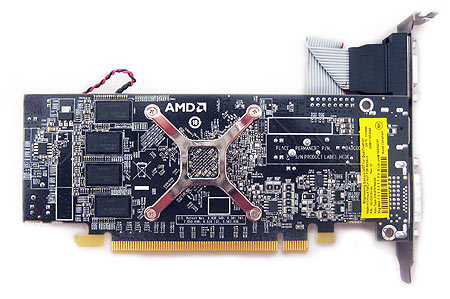

Radeon HD 5570: Referenssiohjain

Radeon HD 5570 ei todellakaan näytä sellaiselta ohjaimelta, josta löytyisi 400 shader-yksikköä. Kenties tämä johtuu siirtymisestä 40 nanometrin valmistustekniikkaan, joka pienentää lämmöntuotantoa eikä tarvetta suurelle tuulettimelle ole. Rehellisesti sanoen ulkonäöltään sen muistuttaa Radeon HD 4550:tä aktiivijäähdytyksellä. Pienuudesta on paljon hyötyä: se sopii hyvin microATX-HTPC-koneisiin (jopa mini-ITX-koteloihin).

Radeon HD 5570 ei tarvitse lisävirtaa, kuten ei tarvitse tehokkaampi Radeon HD 5670. Ennakkoon arvellemme 5570:n tehonkulutuksen olevan niin levossa kuin rasituksessakin alhaisemmat. Se olisi hyvä uutinen, sillä 5670 tuo tauluun tässäkin tilastossa hyvät luvut.

Jäähdytin on todella pieni. Parasta kuitenkin, että se riittää pitämään lämmöt alhaalla, kuten edempänä tulemme näkemään.

Radeon HD 5570:stä puuttuu kokonaan CrossFire-silta, mutta AMD:n mukaan alemman teholuokan kortit toimivat hyvin CrossFiressä ilman sitäkin. On vaikea kuvitella tilannetta, jossa kahdesta Radeon HD 5570:tä olisi mitään iloa. Jo yksi Radeon HD 5770 maksaa vähemmän kuin kaksi Radeon HD 5570:tä, ja siitä löytyy vielä 800 shaderia sekä nopea GDDR5-muisti. Tässä oppikirjaesimerkki tilanteesta, jossa yksi hyvä ohjain on järkevämpi ratkaisu kuin kaksi huonoa.

Referenssimallista löytyy VGA-, DVI- ja HDMI-ulostulot. Tilanne on hieman kummallinen, sillä kolmennäytön konfiguraatioon tarvittaisiin DisplayPort-ulostulo. Näin ollen mallimme ei ole yhteensopiva kolmen näytön kanssa. Kuten aiemminkin, on valmistajilla yleensä vapaat kädet liitäntöjen suhteen, joten julkaisun jälkeen tulemme näkemään varmasti malleja, joista löytyy mainittu DisplayPort.

Referenssimallissamme käytetään muisteina Samsungin K4W1G1646E-HC11:tä, joka on asetettu 900 MHz:n taajuudelle. Ylikellotuksessa huomasimme muistien venyvän reippaasti. Muistit kuitenkin vaihtelevat valmistajakohtaisesti.

Muistuttaa Radeon HD 5670:n GPU:ta, eikö niin. Hyvin huomattu, sillä juuri sellainen siinä on.

Kommentoi artikkelia

Kirjaudu sisään